AI -modellen hebben binnenkort meer opslag nodig

Wanneer mensen praten over de “grootte” van een AI -model, verwijzen ze naar het aantal “parameters” dat het bevat. Een parameter is een variabele in het AI -model die bepaalt hoe het de uitvoer genereert, en elk bepaald AI -model kan miljarden van deze parameters hebben.

Ook aangeduid als modelgewichten, bezetten deze parameters opslagruimte om correct te werken – en wanneer een AI -model miljarden parameters heeft, kunnen opslagvereisten snel ballon.

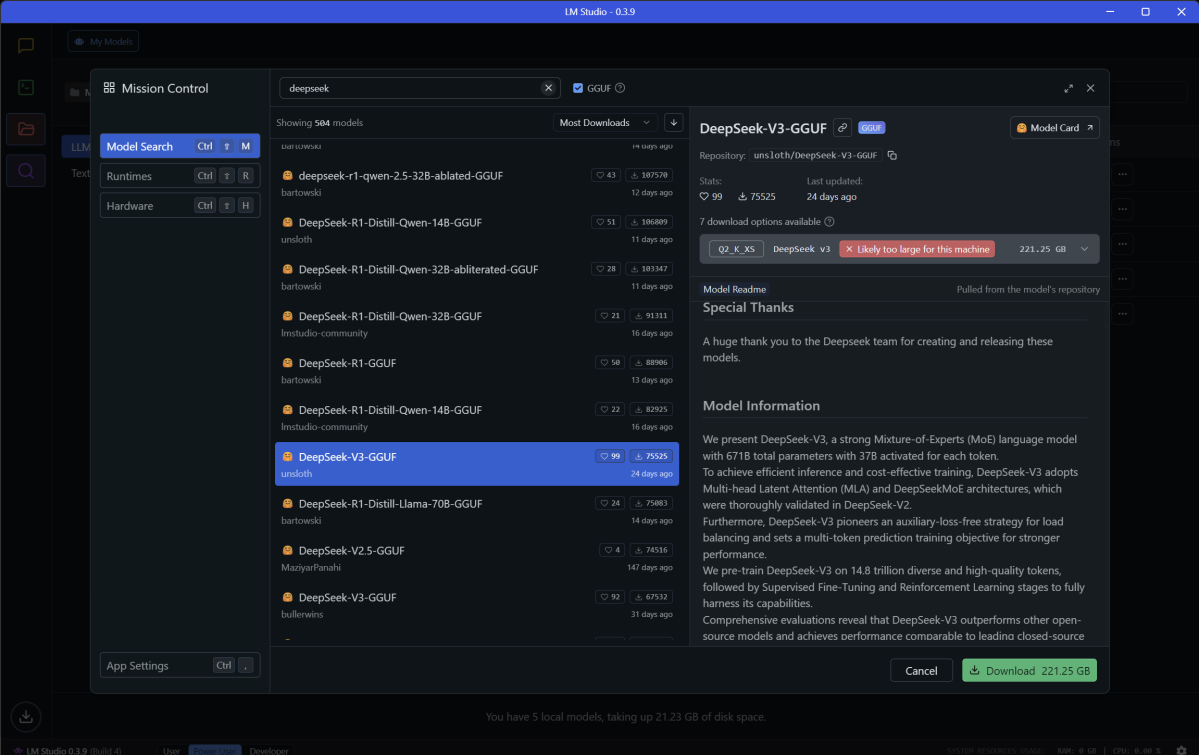

Hier zijn een paar huidige voorbeelden:

- Google Gemma 2 – 1.71GB (2 miljard parameters)

- Meta LLAMA 3.1 – 4,92 GB (8 miljard parameters)

- Qwen 2.5 Coder – 8,52 GB (14 miljard parameters)

- Meta lama 3.3 Instruct – 37.14GB (70 miljard parameters)

- Deepseek V3 – 221.25 GB (671 miljard parameters)

Zoals u kunt zien, neemt de opslagruimte die wordt verbruikt door een LLM toe met de grootte van de parameters. Hetzelfde geldt ook voor andere soorten generatieve AI -modellen. Stabiele diffusie v1.4 neemt bijvoorbeeld ongeveer 4 GB in beslag, terwijl stabiele diffusie XL meer dan 13 GB verbruikt. Openai’s Whisper, een spraak-to-text-model, verbruikt tussen 1 GB en 6 GB, afhankelijk van of u een lichtgewicht variant of het volledige vetmodel kiest.

Matt Smith / Foundry

Maar er is iets anders dat ook toeneemt met de grootte van de parameters van een AI -model: de intelligentie ervan. LLAMA 3.1 405B, de grootste versie van het AI -model van Meta, scoorde 88.6 op de MMLU -benchmarkwat betekent dat het 88,6 procent van de vragen in de benchmark correct beantwoordde. Ondertussen scoorde het mindere LLAMA 3,1 70B -model 86 en de nog minder lama 3.1 8B scoorde 73.

Voor alle duidelijkheid, er zijn manieren om de intelligentie van AI -modellen te verbeteren zonder de parameters te vergroten. Dat was een belangrijke innovatie van Deepseek-V3het Chinese AI -model dat in december 2024 uit het niets naar voren kwam met prestaties die de beste van Openai wedijveren.

Toch zijn de allerbeste AI -modellen enorm. Deepseek-V3 wordt verondersteld kleiner te zijn dan de modellen van Openai-ik zeg “vermoedelijk” omdat Openai geen parametertellingen bekendmaakt voor zijn geavanceerde modellen-en toch is het nog steeds meer dan 220 GB. De meeste apps vereisen geen lokale installatie van DeepSeek-V3 om AI-functies van stroom te voorzien, maar ze willen misschien middelgrote modellen zoals Qwen 2,5 14b (8,52 GB) of LLAMA 3,3 70B (37.14GB) gebruiken.

En het wordt erger voor je harde schijf, omdat verschillende AI -modellen verschillende sterke punten hebben. Sommige zijn beter voor het schrijven in natuurlijke taal, terwijl anderen zijn geoptimaliseerd voor logische redenering of stapsgewijze planning. Dat betekent dat u niet zomaar kunt omgaan met één lokaal geïnstalleerd AI -model. Je zult er waarschijnlijk een paar willen. Misschien tientallen.

Source link