Anthropic hat gerade ein neues Modell namens Claude 3.7 Sonnet veröffentlicht, und obwohl ich immer an den neuesten KI -Funktionen interessiert bin, war es der neue “erweiterte” Modus, der mir wirklich ins Auge geriet. Es erinnerte mich an wie Openai Zuerst debütierte sein O1 -Modell für Chatgpt. Es bot eine Möglichkeit, auf O1 zuzugreifen, ohne ein Fenster mit dem ChatGPT 4O -Modell zu verlassen. Sie können “/Vernunft” und die KI eingeben Chatbot würde stattdessen O1 verwenden. Es ist jetzt überflüssig, obwohl es immer noch in der App funktioniert. Unabhängig davon, dass die tiefere, strukturiertere Argumentation von beiden mich dazu brachte, zu sehen, wie sie gegeneinander gehen würden.

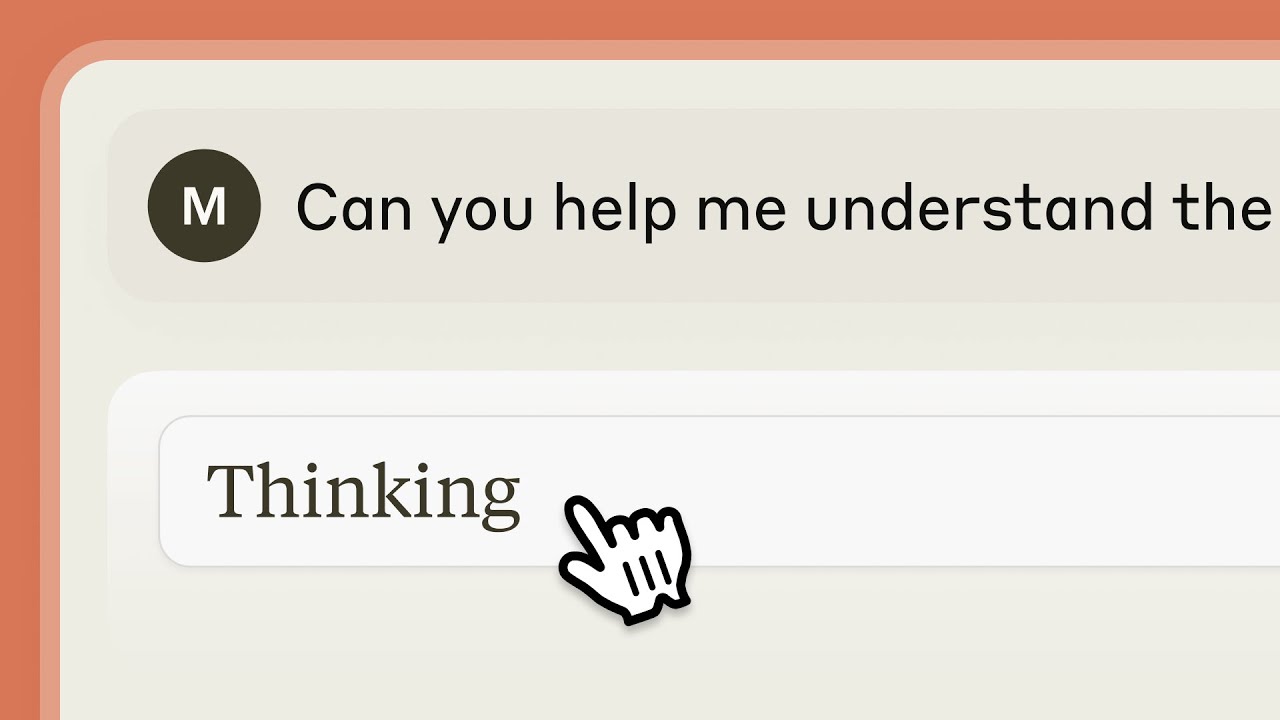

Der erweiterte Modus von Claude 3.7 ist als hybrides Argumentationstool ausgelegt, mit dem Benutzer die schnelle, konversationsbedingte Antworten und eingehende, schrittweise Problemlösung umschalten können. Es braucht Zeit, um Ihre Eingabeaufforderung zu analysieren, bevor Sie ihre Antwort abgeben. Das macht es großartig für Mathematik, Codierung und Logik. Sie können das Gleichgewicht zwischen Geschwindigkeit und Tiefe sogar fein stimmen und ihm eine zeitliche Begrenzung geben, um über seine Reaktion nachzudenken. Anthropische Positionen, um die KI für reale Anwendungen nützlicher zu machen, die überschichtete, methodische Problemlösungen erfordern, im Gegensatz zu Reaktionen auf Oberflächenebene.

Der Zugriff auf Claude 3.7 erfordert ein Abonnement für Claude Pro. Daher habe ich beschlossen, die Demonstration im folgenden Video stattdessen als Test zu verwenden. Um den erweiterten Denkmodus herauszufordern, bat Anthropic die KI, das beliebte, Vintage -Wahrscheinlichkeitsrätsel zu analysieren und zu erklären, das als das Monty Hall -Problem bekannt ist. Es ist eine täuschend schwierige Frage, die viele Menschen stapft, selbst diejenigen, die sich gut in Mathematik betrachten.

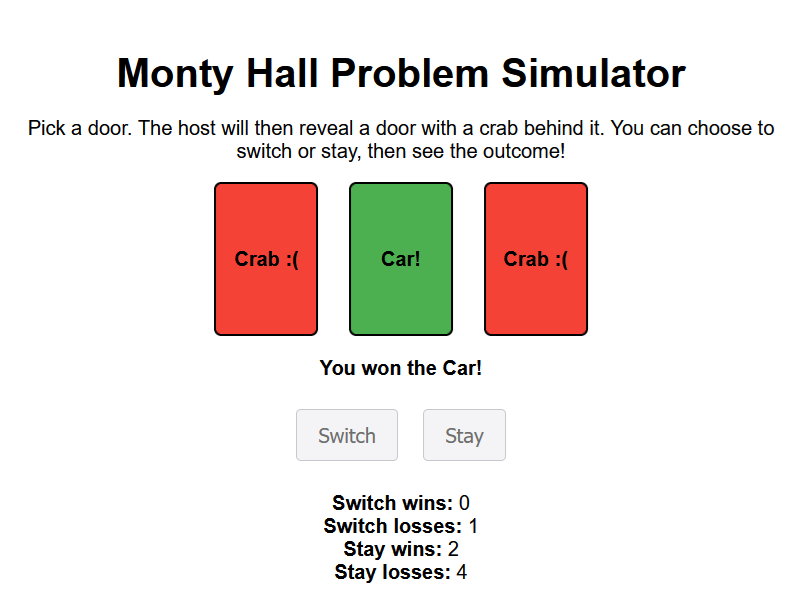

Das Setup ist einfach: Sie sind in einer Spielshow und haben gebeten, eines von drei Türen auszuwählen. Hinter einem befindet sich ein Auto; Hinter den anderen, Ziegen. Aus einer Laune heraus beschloss Anthropic, mit Krabben anstelle von Ziegen zu gehen, aber das Prinzip ist dasselbe. Nachdem Sie Ihre Wahl getroffen haben, öffnet der Gastgeber, der weiß, was sich hinter jeder Tür befindet, einen der verbleibenden beiden, um eine Ziege (oder eine Krabbe) zu enthüllen. Jetzt haben Sie die Wahl: Bleiben Sie bei Ihrer ursprünglichen Auswahl oder wechseln Sie zur letzten ungeöffneten Tür. Die meisten Menschen gehen davon aus, dass es keine Rolle spielt, aber kontraintuitiv bietet Switing Ihnen tatsächlich eine Gewinnchance von 2/3, während Sie bei Ihrer ersten Wahl nur eine 1/3 -Wahrscheinlichkeit haben.

Mürrische Entscheidungen

Mit einem verlängerten Denken verfolgte Claude 3.7 einen gemessenen, fast akademischen Ansatz, um das Problem zu erklären. Anstatt nur die richtige Antwort anzugeben, legte sie die zugrunde liegende Logik in mehreren Schritten sorgfältig fest, wobei betont, warum sich die Wahrscheinlichkeiten nach dem Host eine Krabbe enthüllt. Es erklärte auch nicht nur in trockenen Mathematik. Claude durchlief hypothetische Szenarien und demonstrierte, wie sich die Wahrscheinlichkeiten über wiederholte Versuche herausstellten, und erleichterte es viel einfacher zu erfassen, warum das Schalten immer die bessere Bewegung ist. Die Antwort war nicht gehetzt; Es fühlte sich an, als würde ein Professor mich langsam und absichtlich durch ihn führen, um sicherzustellen, dass ich wirklich verstand, warum die gemeinsame Intuition falsch war.

Chatgpt O1 bot nur einen großen Teil der Aufschlüsselung an und erklärte das Problem gut. Tatsächlich erklärte es es in mehreren Formen und Stilen. Zusammen mit der grundlegenden Wahrscheinlichkeit durchlief es auch die Spieltheorie, die narrativen Ansichten, die psychologische Erfahrung und sogar einen wirtschaftlichen Zusammenbruch. Wenn überhaupt, war es etwas überwältigend.

Gameplay

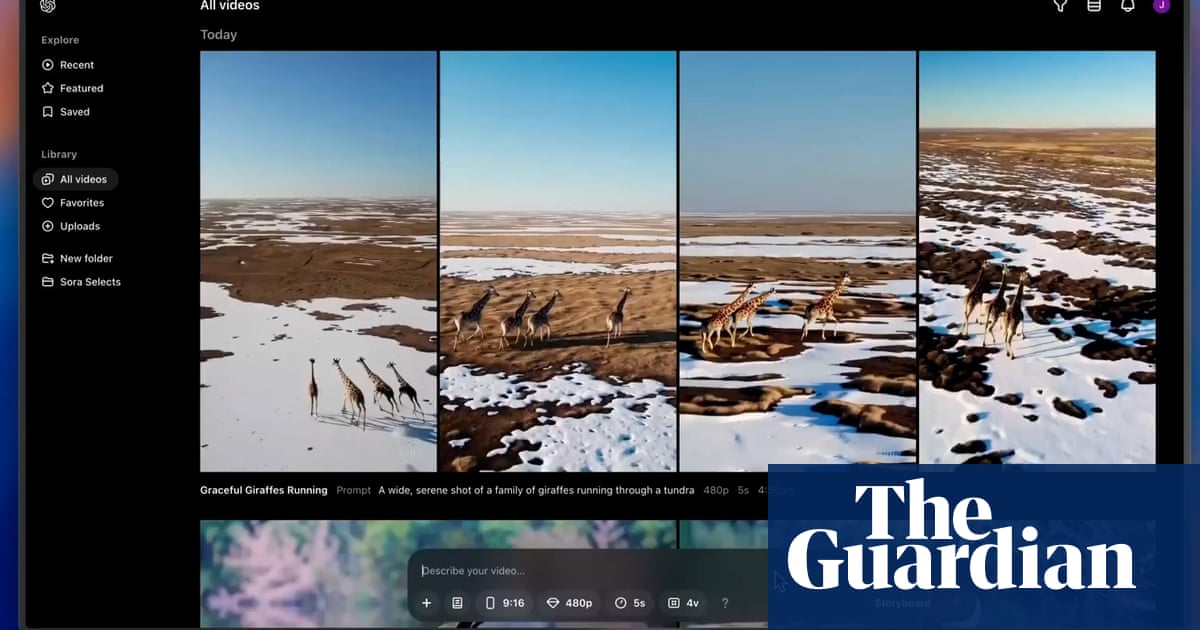

Das ist jedoch nicht alles, was Claude’s erweitertes Denken tun könnte. Wie Sie im Video sehen können, konnte Claude sogar eine Version des Monty Hall -Problems in ein Spiel machen, das Sie direkt im Fenster spielen konnten. Der Versuch der gleichen Eingabeaufforderung mit Chatgpt O1 tat nicht ganz gleich. Stattdessen schrieb Chatgpt ein HTML -Skript für eine Simulation des Problems, das ich in meinem Browser speichern und öffnen konnte. Wie Sie unten sehen können, hat aber ein paar zusätzliche Schritte unternommen.

Während es mit ziemlicher Sicherheit kleine Qualitätsunterschiede gibt, je nachdem, an welcher Art von Code oder der Mathematik Sie arbeiten, bieten sowohl Claude’s Extended Thinking als auch Chatgpts O1 -Modell solide, analytische Ansätze für logische Probleme. Ich kann den Vorteil sehen, dass die Zeit und die Tiefe der Argumentation angepasst werden, die Claude anbietet. Das heißt, es sei denn, Sie haben es nicht zu viel Zeit und produziert eine Menge Inhalte aus dem Nachdenken.

Die Fähigkeit, das Problem als Simulation im Chat zu machen, ist viel bemerkenswerter. Es macht Claude flexibler und leistungsfähiger, auch wenn die tatsächliche Simulation wahrscheinlich einen sehr ähnlichen Code wie das von ChatGPT geschriebene HTML verwendet.

Sie könnten auch mögen

Source link