- SOCAMM ist ein neuer modularer Speicherformfaktor, der für NVIDIA -Systeme ausschließt

- Laut Micron bietet SoCamm eine hohe Bandbreite, eine geringe Leistung und einen kleineren Fußabdruck

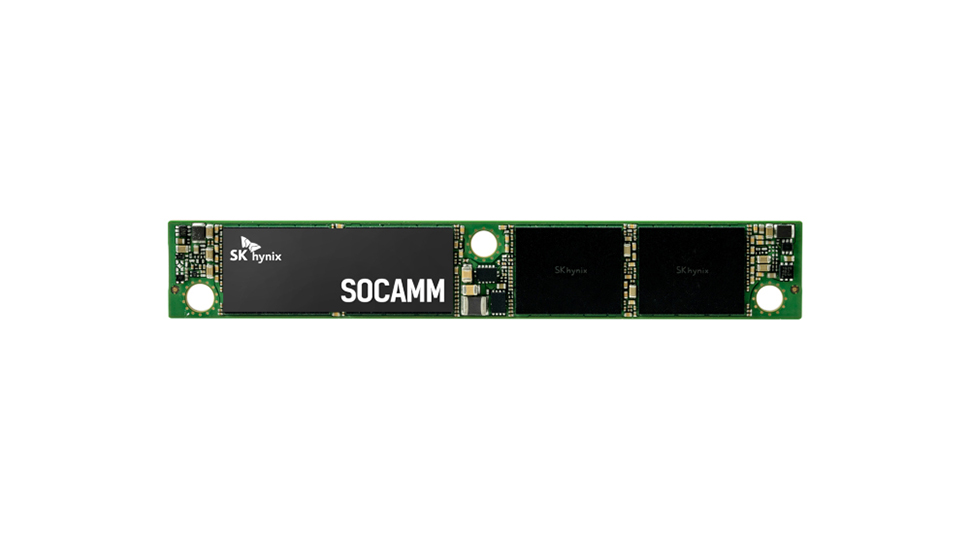

- SK Hynix plant die Produktion von SOCAMM als KI -Infrastrukturnachfrage wächst

Bei der letzten Nvidia GTC 2025, Memory Makers Micron und SK Hynix haben ihre jeweiligen SocAMM -Lösungen abgenommen.

Dieser neue modulare Speicherformfaktor soll das volle Potenzial von AI -Plattformen freischalten und wurde ausschließlich für die Grace Blackwell -Plattform von Nvidia entwickelt.

SOCAMM oder Small Excrine Compression Angehängte Speichermodul basiert auf LPDDR5x und soll die wachsende Leistung und die Effizienzanforderungen auf KI -Servern entsprechen. Der Formfaktor bietet Berichten zufolge eine höhere Bandbreite, einen geringeren Stromverbrauch und einen kleineren Fußabdruck im Vergleich zu herkömmlichen Speichermodulen wie RDIMMS und MRDIMMS. SOCAMM ist spezifisch für die KI -Architektur von Nvidia und kann daher nicht in verwendet werden AMD oder Intel Systeme.

Kostengünstiger

Micron kündigte an, dass es die ersten sein wird, die SOCAMM -Produkte in Volumen versenden wird, und seine 128 -GB -SoCamm -Module sind für die NVIDIA GB300 Grace Blackwell Ultra Superchip ausgelegt.

Nach Angaben des Unternehmens liefern die Module mehr als das 2,5-fache der Bandbreite von Rdimms, während sie ein Drittel der Leistung anwenden.

Das kompakte 14x90mm -Design soll effiziente Serverlayouts und thermisches Management unterstützen.

“AI treibt eine Paradigmenverschiebung im Computerverschiebung vor, und das Gedächtnis steht im Mittelpunkt dieser Entwicklung”, sagte Raj Narasimhan, Senior Vice President und General Manager von Microns Rechen- und Networking -Geschäftseinheit.

“Die Beiträge von Micron zur Nvidia Grace Blackwell-Plattform ergeben Leistung und Stromsparvorteile für AI-Trainings- und Inferenzanwendungen.”

SK Hynix präsentierte als Teil eines breiteren KI-Speicherportfolios auch eine eigene Socamm-Lösung mit geringer Leistung bei GTC 2025.

Im Gegensatz zu Micron stand das Unternehmen nicht zu sehr detailliert, sagte aber, dass es SOCAMM als Schlüsselangebot für die zukünftige KI -Infrastruktur positioniert und plant, die Massenproduktion zu beginnen, „im Einklang mit der Entstehung des Marktes“.

“Wir sind stolz darauf, unsere Besetzung von branchenführenden Produkten bei GTC 2025 zu präsentieren”, sagte SK Hynixs Präsident und Leiter von AI Infra Juseon (Justin) Kim.

“Mit einer differenzierten Wettbewerbsfähigkeit im KI -Speicherplatz sind wir auf dem richtigen Weg, um unsere Zukunft als vollständigen Stack AI -Speicheranbieter voranzutreiben.”

Sie könnten auch mögen

Source link