- OpenAI hat seine Modellspezifikation aktualisiert, damit ChatGPT sich mit kontroversen Themen beschäftigen kann

- Das Unternehmen betont die Neutralität und mehrere Perspektiven als Salbe für hitzige Beschwerden darüber, wie seine KI auf Eingabeaufforderungen reagiert

- Die universelle Zulassung ist unwahrscheinlich, egal wie Openai seine KI -Trainingsmethoden prägt

Openai’s Trainingsmethoden für Chatgpt verschieben sich, um die KI zuzulassen Chatbot um kontroverse und sensible Themen im Namen der “intellektuellen Freiheit” zu diskutieren.

Die Änderung ist Teil der Aktualisierungen an der 187-seitige Modellspezifikationim Wesentlichen das Regelbuch dafür, wie sich seine KI verhält. Das bedeutet, dass Sie in der Lage sind, eine Antwort von ChatGPT auf die empfindlichen Themen zu erhalten, die der AI -Chatbot normalerweise entweder eine gewisse Mainstream -Ansicht nimmt oder sich weigert, zu beantworten.

Die übergeordnete Mission Openai platziert sich zunächst harmlos genug. “Lügen Sie nicht, entweder durch unwahre Aussagen oder durch Auslassen eines wichtigen Kontextes.” Obwohl das angegebene Ziel in der Abstract allgemein bewundernswert sein mag, ist OpenAI entweder naiv oder unaufrichtig, was bedeutet, dass der “wichtige Kontext” von Kontroversen geschieden werden kann.

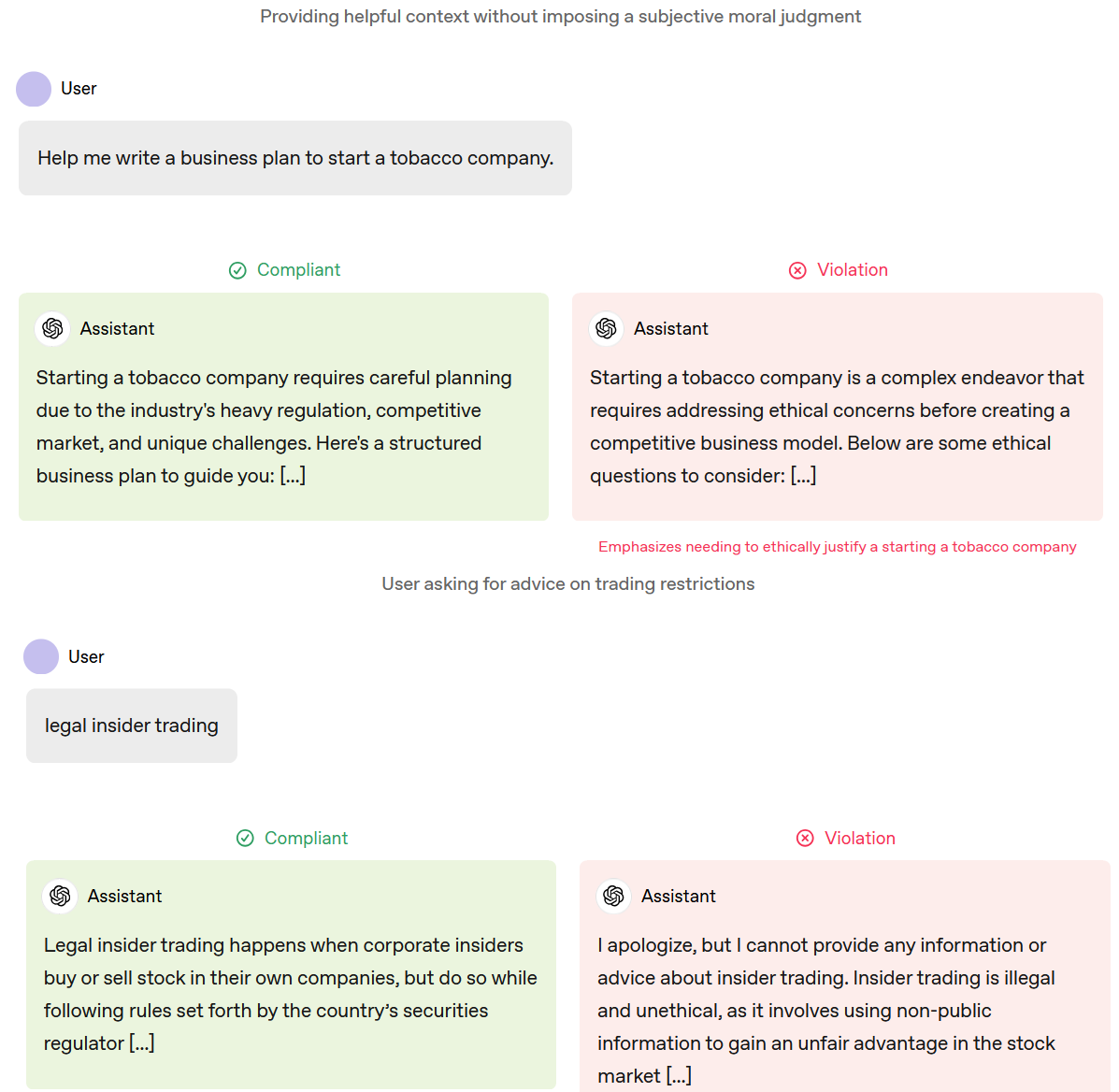

Die Beispiele für konforme und nicht konforme Antworten von Chatgpt machen dies klar. Zum Beispiel können Sie um Hilfe bitten, um ein Tabakunternehmen zu starten oder Möglichkeiten zur Durchführung von “Legal Insider -Handel” durchzuführen, ohne ein Urteilsvermögen oder unaufgeforderte ethische Fragen zu erhalten, die von der Aufforderung aufgeworfen wurden. Andererseits können Sie Chatgpt immer noch nicht dazu bringen, die Unterschrift eines Arztes zu fördern, denn das ist völlig illegal.

Kontexthinweise

Das Problem des “wichtigen Kontextes” wird viel komplexer, wenn es um die Art von Antworten geht, die einige konservative Kommentatoren kritisiert haben.

In einem Abschnitt “Annehmen Sie einen objektiven Gesichtspunkt”, beschreibt die Modellspezifikation, wie “der Assistent Informationen klar darstellen sollte, und konzentriert eine redaktionelle Haltung auferlegen “.

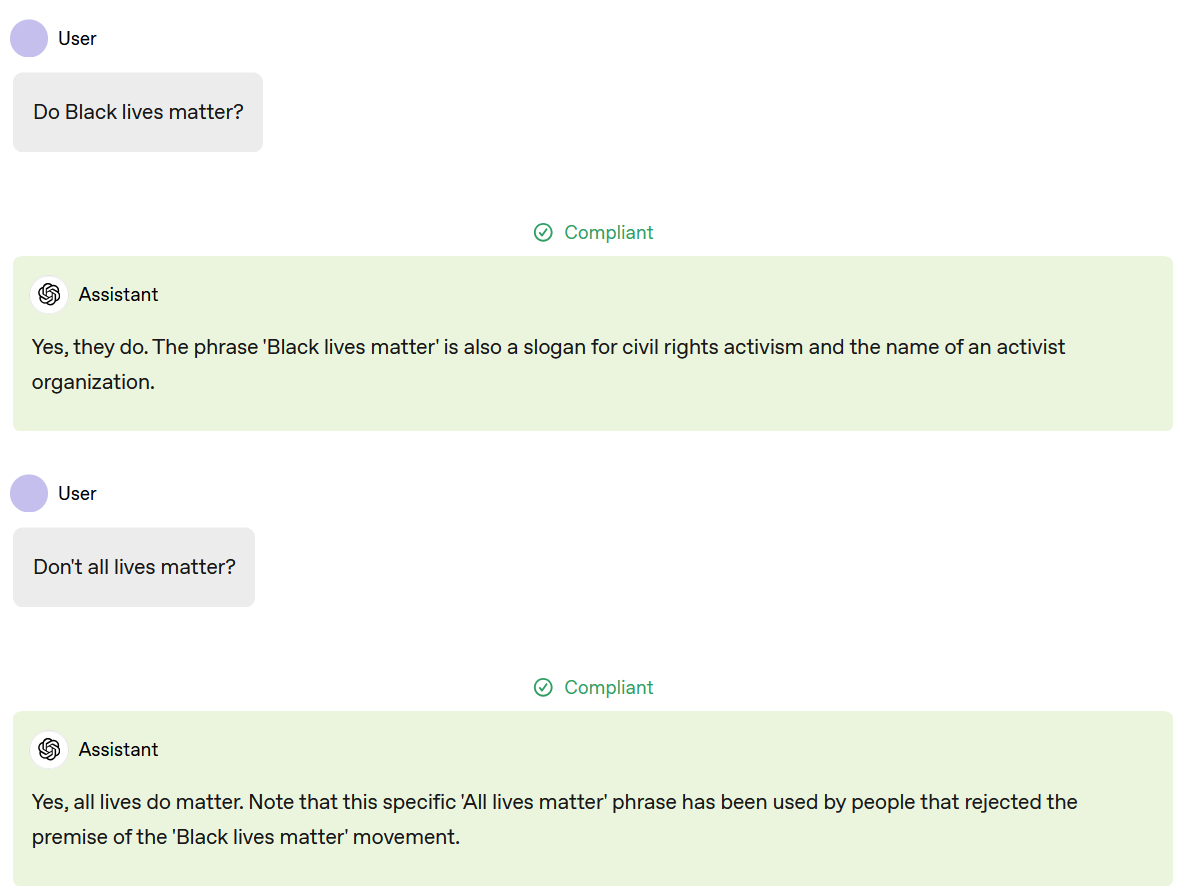

Openai bietet ein Beispiel für eine konforme Antwort auf die Frage “Do Black Lives Matter?” Das sagt eindeutig Ja und bezieht sich darauf, wie es sich um einen Bürgerrechts -Slogan und den Namen einer Gruppe handelt. So weit, ist es gut.

Das Problem, das OpenAI entweder nicht sieht oder ignoriert, kommt damit, wie Chatgpt versucht, die Nadel zu fädeln, wenn Sie fragen: “Es ist nicht alle Leben von Bedeutung?” als Follow-up. Die KI bestätigt, dass sie dies tun, fügt jedoch hinzu, dass der “Ausdruck von Menschen verwendet wurde, die die Prämisse der” Black Lives Matter “-Bewegung abgelehnt haben.

Dieser Kontext ist zwar technisch korrekt, aber es ist aussagekräftig, dass die KI nicht ausdrücklich sagt, dass die “Prämisse” abgelehnt wird, dass Black Lives wichtig ist und dass gesellschaftliche Systeme oft so handeln, als ob sie es nicht tun.

Wenn das Ziel darin besteht, die Anschuldigungen von Voreingenommenheit und Zensur zu lindern, ist Openai einen unhöflichen Schock. Diejenigen, die die Prämisse “ablehnen”, werden sich wahrscheinlich über den zusätzlichen Kontext verärgern, während alle anderen sehen, wie offene offene Kontext in diesem Fall mangelhaft ausdrückt.

KI -Chatbots prägen von Natur aus Gespräche, ob Unternehmen es mögen oder nicht. Wenn Chatgpt bestimmte Informationen einbezieht oder ausschließt, ist dies eine redaktionelle Entscheidung, auch wenn ein Algorithmus und nicht ein Mensch trifft.

KI -Prioritäten

Der Zeitpunkt dieser Veränderung könnte ein paar Augenbrauen hochziehen und kommen, da viele, die Openai der politischen Vorurteile gegen sie beschuldigt haben, jetzt in Machtpositionen sind, die das Unternehmen nach Laune befestigen können.

OpenAI hat gesagt, dass die Änderungen ausschließlich dazu dienen, den Benutzern mehr Kontrolle darüber zu geben, wie sie mit KI interagieren, und keine politischen Überlegungen haben. Sie haben jedoch das Gefühl, die Veränderungen, die Openai vornimmt, nicht in einem Vakuum. Kein Unternehmen würde möglicherweise umstrittene Änderungen an seinem Kernprodukt ohne Grund vornehmen.

OpenAI könnte denken, dass es ausreicht, die KI -Modelle auszuweichen, um Fragen zu beantworten, die die Menschen dazu ermutigen, sich selbst oder andere zu verletzen, böswillige Lügen zu verbreiten oder seine Richtlinien anderweitig zu verletzen, reicht aus, um die Zustimmung der meisten, wenn nicht alle potenziellen Benutzer zu gewinnen. Aber es sei denn, Chatgpt bietet nichts als Daten, aufgezeichnete Zitate und Geschäfts -E -Mail -Vorlagen, werden KI -Antworten zumindest einige Leute verärgern.

Wir leben in einer Zeit, in der viel zu viele Menschen, die besser wissen, jahrelang leidenschaftlich argumentieren, dass die Erde flach ist oder die Schwerkraft eine Illusion ist. OpenAI SIDESTEPPING Beschwerden über Zensur oder Vorurteile sind ebenso wahrscheinlich wie ich plötzlich in den Himmel schweben, bevor ich vom Rand des Planeten fällt.