Selbst wenn diese KI -Suchwerkzeuge Quellen zitierten, wiesen sie Benutzer häufig auf syndizierte Versionen von Inhalten auf Plattformen wie Yahoo News an und nicht auf Original -Publisher -Websites. Dies geschah auch in Fällen, in denen Verlage formelle Lizenzvereinbarungen mit KI -Unternehmen hatten.

Die URL -Herstellung wurde als ein weiteres erhebliches Problem. Mehr als die Hälfte der Zitate von Googles Gemini und GROK 3 führte zu fabrikierten oder kaputten URLs, was zu Fehlerseiten führte. Von 200 von GROK 3 getesteten Zitaten führte 154 zu kaputten Links.

Diese Themen führen zu erheblichen Spannungen für Verlage, die schwierige Entscheidungen ausgesetzt sind. Das Blockieren von KI -Crawlern kann zu einer vollständigen Zuschreibungsverlust führen, während sie zulässt, dass sie eine weit verbreitete Wiederverwendung ermöglicht, ohne den Verkehr zurück zu den eigenen Websites der Verlage zu bringen.

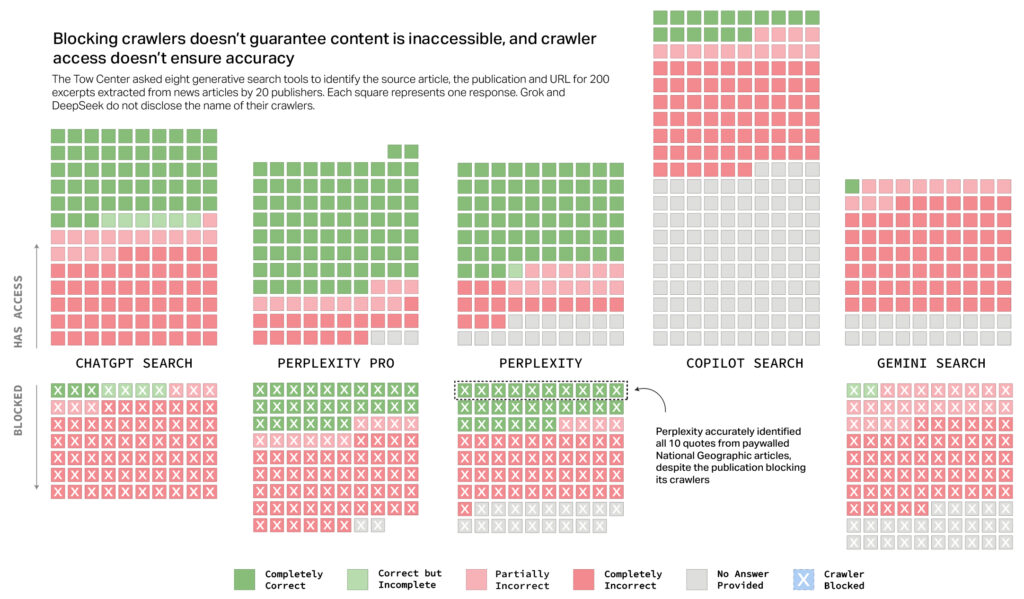

Eine Grafik von CJR zeigt, dass Blockiercrawler nicht bedeutet, dass KI -Suchanbieter die Anfrage ehren.

Kredit:

CJR

Mark Howard, Chief Operating Officer des Time Magazine, äußerte CJR besorgt darüber, dass Transparenz und Kontrolle darüber sicherstellen, wie der Inhalt der Zeit über AI-generierte Suchanfragen erscheint. Trotz dieser Probleme sieht Howard in zukünftigen Iterationen Verbesserungen für Verbesserungen und behauptet: “Heute ist das schlechteste, was das Produkt jemals sein wird”, unter Berufung auf erhebliche Investitionen und technische Bemühungen, die auf die Verbesserung dieser Tools abzielen.

Howard hat jedoch auch einige Benutzerbeschädigungen geschuldet, was darauf hindeutet, dass es die Schuld des Benutzers ist, wenn sie nicht skeptisch gegenüber der Genauigkeit der kostenlosen KI -Tools sind: “Wenn jemand als Verbraucher derzeit glaubt, dass eines dieser freien Produkte zu 100 Prozent genau sein wird, beschämen Sie sich.”

OpenAI und Microsoft gaben CJR Anweisungen zur Bestätigung der Erhalt der Erkenntnisse an, haben jedoch die spezifischen Probleme nicht direkt angesprochen. OpenAI stellte das Versprechen fest, Publisher zu unterstützen, indem er den Verkehr durch Zusammenfassungen, Zitate, klare Links und Zuschreibungen vorantreibt. Microsoft erklärte, dass es sich an Roboter -Ausschlussprotokolle und Publisher -Direktiven hält.

Der neueste Bericht baut auf Frühere Erkenntnisse Veröffentlicht vom TOW Center im November 2024, in dem ähnliche Genauigkeitsprobleme bei der Umgang mit News-bezogenen Inhalten festgestellt wurden. Weitere Informationen zum ziemlich umfassenden Bericht finden Sie unter Website von Columbia Journalism Review.

Source link