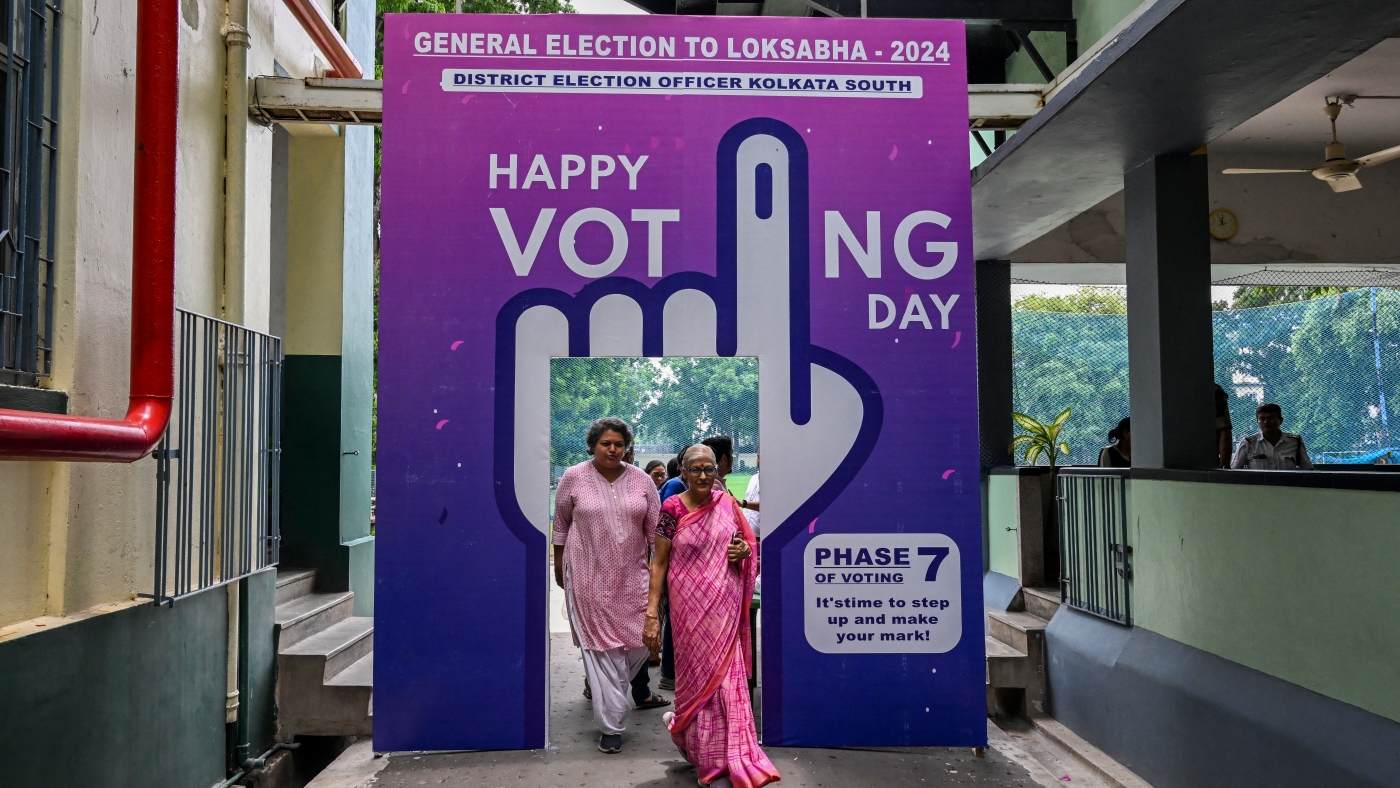

Kiezers vertrekken nadat ze hun stem hebben uitgebracht in een stembureau in de laatste fase van het stemmen voor de algemene verkiezingen van India, in Kolkata op 1 juni 2024. Er werden kunstmatige intelligentie-instrumenten gebruikt om memes en beelden te creëren over politieke rivalen in India en elders in de wereld.

Dibyangshu Sarkar/AFP via Getty Images

onderschrift verbergen

onderschrift wisselen

Dibyangshu Sarkar/AFP via Getty Images

In januari pakten duizenden kiezers in New Hampshire hun telefoon om te horen wat klonk als president Biden De Democraten vertellen dat ze niet moeten stemmen tijdens de voorverkiezingen van de staat, over slechts enkele dagen.

“We kennen de waarde van het stemmen op de Democraten als onze stemmen tellen. Het is belangrijk dat u uw stem bewaart voor de verkiezingen in november”, zei de stem aan de lijn.

Maar het was Biden niet. Het was een diep nep gemaakt met kunstmatige intelligentie – en de uiting van de angst dat de wereldwijde verkiezingsgolf van 2024 zou worden gemanipuleerd met nepfoto’s, audio en video, als gevolg van de snelle vooruitgang in generatieve AI-technologie.

“De nachtmerriesituatie was de dag ervoor, de dag van de verkiezingen, de dag na de verkiezingen; een of ander bombshell-beeld, een of andere bombshell-video of -audio zou de wereld gewoon in vuur en vlam zetten”, zegt Hany Farid, een professor aan de Universiteit van Californië in Berkeley. die gemanipuleerde media bestudeert.

De Deepfake van Biden bleek te zijn gemaakt in opdracht van een Democratisch politiek adviseur die zei dat hij het deed om alarm te slaan over AI. Hij kreeg een boete van $ 6 miljoen van de FCC en werd aangeklaagd wegens strafrechtelijke vervolging in New Hampshire.

Maar naarmate 2024 vorderde, kwam de gevreesde golf van misleidende, gerichte deepfakes niet echt tot stand.

“Het was niet helemaal het jaar van AI-verkiezingen zoals veel mensen hadden voorspeld”, zegt Zeve Sanderson, die bij het Center for Social Media and Politics van NYU onderzoekt hoe digitale informatie de samenleving verandert.

In plaats daarvan was het meest zichtbare gebruik van AI in veel landen het creëren van memes en inhoud waarvan de kunstmatige oorsprong niet verborgen bleef. Vaak werden ze openlijk gedeeld door politici en hun aanhangers.

Farid zei dat hij zich dit jaar meer zorgen maakte over dit soort ‘dood door duizend bezuinigingen’ dan over het AI-bomscenario.

“Ik denk niet dat de beelden bedoeld zijn om duidelijk misleidend te zijn, maar ze zijn bedoeld om een verhaal over te brengen, en propaganda werkt”, zei hij. “Ik denk echt dat er sprake was van een algemene vervuiling van het informatie-ecosysteem, waarbij mensen het gewoon begonnen op te geven.”

Een dode dictator weer tot leven wekken

Neem Indonesië, waar de politieke partij Golkar AI gebruikte Soeharto reanimerende oude dictator die in 2008 stierf.

“Ik ben Soeharto, de tweede president van Indonesië”, zegt de AI Soeharto voordat hij de kandidaten van de partij steunt, in een video die door de vice-voorzitter van Golkar op de sociale mediasite X is geplaatst. De nep-Soeharto zegt dat de kandidaten van Golkar ‘mijn droom over de vooruitgang van Indonesië zullen voortzetten’.

Kort daarna werd de schoonzoon van Soeharto – die ook de steun van Golkar had – tot president gekozen.

AI-memes waren ook gangbaar in India, waar afgelopen voorjaar de grootste democratische oefening ter wereld plaatsvond.

In mei vertelde een handelaar genaamd Dilip, die maar één naam heeft, op een bazaar in Jaipur aan NPR dat zijn vrienden hem door AI gegenereerde memes hadden doorgestuurd op WhatsApp, het populaire berichtenplatform van Meta.

Hij zei dat hij degenen leuk vond die de spot dreven met oppositieleider Rahul Gandhi, zoals een versie waarin een AI-versie van Gandhi werd afgebeeld als een domme dief, die zich al het geld voorstelde dat hij zou stelen als hij zou winnen.

Toch zei Dilip, ondanks de memes, dat hij al een besluit had genomen over op wie hij zou stemmen.

Een generatieve AI-kunstenaar in India, die professioneel de naam Sahid SK draagt, zei dat hij memes nam omdat er minder risico bestond om door boze kandidaten te worden aangeklaagd wegens smaad. Hij zei dat memes een knipoog zijn en geen regelrechte verkeerde voorstelling van zaken.

“Ik denk dat dit de enige reden is waarom we bij deze verkiezingen niet veel deepfakes hebben gezien. Omdat iedereen bang is voor juridische kennisgevingen”, zei Sahid SK.

In India en andere landen werden talloze valse en misleidende verhalen verspreid zonder dat er gebruik werd gemaakt van AI – in plaats daarvan via bewerkte en vervalste video’s die bekend staan als ‘cheapfakes’.

Musk en Trump omarmen door AI gegenereerde memes

In de VS besloegen politieke memes en virale video’s het hele spectrum van gephotoshopte beelden en clips die uit hun context waren gehaald tot door AI gegenereerde portretten van vice-president Kamala Harris. Sovjet-kleding en van Zwarte Amerikanen steun aan voormalig president Donald Trump.

BROWNSVILLE, TEXAS – 19 NOVEMBER: De Amerikaanse president-elect Donald Trump en Elon Musk kijken naar de lancering van de zesde testvlucht van de SpaceX Starship-raket op 19 november 2024 in Brownsville, Texas. De miljardair-eigenaar van SpaceX, Elon Musk, een vertrouweling van Trump, is aangetrokken om samen met de voormalige presidentskandidaat Vivek Ramaswamy leiding te geven aan het nieuwe Department of Government Efficiency. (Foto door Brandon Bell/Getty Images)

Brandon Bell/Getty Images

onderschrift verbergen

onderschrift wisselen

Brandon Bell/Getty Images

In juli deelde Elon Musk, de eigenaar van X, een nepadvertentie waarin een AI-kloon van Harris’ stem omschrijft zichzelf als “de ultieme diversiteitshuurder”, zonder te onthullen dat de video oorspronkelijk als parodie was gepost.

Musk en andere Trump-aanhangers deelden regelmatig AI-memes Harris en de Democraten bespotten en de voormalige president een boost geven.

Trump plaatste zelf een cartoonachtige AI-afbeelding die beweerde dat Taylor Swift hem steunde – wat ze, voor de duidelijkheid, niet deed.

Sanderson zei dat dit gebruik van AI niet bedoeld is om de gedachten van mensen te veranderen, maar om “hun favoriete kandidaat er patriottisch of nobel uit te laten zien (of) om hun tegenstander er slecht uit te laten zien.” Hij merkte op dat deze manipulaties kunnen worden uitgevoerd met traditionele foto- en videobewerkingstools, maar “generatieve AI maakt het gewoon een stuk eenvoudiger.”

Sanderson waarschuwde ook dat AI mogelijk is gebruikt op manieren die minder detecteerbaar zijn. “Ik denk nog steeds niet dat we een echt goed, rigoureus beeld hebben van hoe generatieve AI op grote schaal werd gebruikt, door wie, voor welke doeleinden”, zei hij.

Bovendien is het moeilijk om een directe lijn te trekken tussen de AI-vervalsingen die dit jaar zijn geïdentificeerd en de manier waarop mensen stemmen, zegt Farid van UC Berkeley.

‘Denk ik dat dit de uitkomst van de verkiezingen heeft veranderd? Nee’, zei hij. “Denk ik dat het de manier van denken van mensen heeft beïnvloed? Ja, ik denk van wel. En ik denk dat het dat zal blijven doen.”

NPR’s Diaa Hadid droeg bij aan verslaggeving vanuit Jaipur en Kolkata, India.