Comino machte die Schlagzeilen mit dem Start von Grando, seinem Wassergekühlten AMD-basierend Arbeitsplatz mit acht Nvidia RTX 5090 GPUS. Während des umfangreichen E-Mail-Austauschs, den ich mit seinem CTO/Mitbegründer und Handelsdirektor hatte, fand ich heraus, dass Grando weitaus vielseitiger ist, als ich erwartet hatte.

Eingraben sein Konfigurator Und einer wird feststellen, dass Sie das System mit bis zu acht RX 7900 XTX GPUs konfigurieren können, weil, warum nicht?

„Ja, wir können 8x 7900XTX mit einer erhöhten Vorlaufzeit packen. Tatsächlich können wir alle 8 packen GPUS + EPYC in einem einzigen System “, sagte mir Alexey Chistov, der CTO von Comino, mir, als ich weiter fragte.

In der Tat, obwohl es derzeit nicht bietet Intel’S vielversprechend ARC GPUWenn der Markt solche Lösungen verlangt.

„Wir können einen Wasserblock für jede GPU entwerfen, es dauert ungefähr einen Monat“, betonte Chistov: „Aber wir entscheiden nicht alle möglichen GPUs, wir wählen bestimmte Modelle und Marken aus. Wir entscheiden uns nur für High-End-GPUs, um den zusätzlichen Preis für die Flüssigkeitskühlung zu rechtfertigen, denn wenn es richtig luftgekühlt funktioniert, warum sich die Mühe machen? Wir versuchen, sich an 1 oder 2 verschiedene Modelle pro Generation zu halten, um nicht mehrere SKUs (Lagerbestände) von Wasserblocks zu haben. Sie können eine haben RTX 4090H200, L40s oder eine andere GPU, für die wir in einem einzigen System einen Wasserblock haben, wenn Ihr Workflow von einer solchen Kombination profitiert. “

Der Rimac von HPC

Wie kann Comino eine solche Flexibilität erreichen? Das Unternehmen stellt sich als Ingenieurfirma mit seinem Slogan stolz “konstruiert, nicht nur versammelt”. Stellen Sie sich Chalino als Rimac von vor HPC: obszön mächtig, flink, agil und teuer. Wie Rimac konzentriert es sich auf die Spitze seiner Geschäfts- und absoluten Leistung.

Das Flaggschiff-Produkt, Grando, ist flüssiggekühlt und wurde von Anfang an bis zu acht GPUs ausgelegt, was bedeutet, dass es sehr wahrscheinlich zukünftiger für mehrere Nvidia Generationen; Mehr dazu ein bisschen.

Eines ihrer Hauptziele, Chistov, sagte zu mir: „Es ist, immer in einen einzigen PCI -Slot zu passen. So können wir alle PCIe -Slots auf dem Motherboard füllen und acht GPUs in einen Grando -Server einfügen. Das Chassis ist auch vom Comino-Team entworfen, sodass alles als “eins” funktioniert. So kann eine Triple-Slot-GPU wie der RTX 5090 so modifiziert werden, dass er in einen einzigen Steckplatz einpasst.

Vor diesem Hintergrund bereitet es eine „Lösung vor, die ohne Drossel auf der Kühlmitteltemperatur von 50 ° C betrieben werden kann. Wenn Sie also die Kühlmitteltemperatur auf 20 ° C fallen lassen und den Kühlmittelfluss auf 3-4 l/m einstellen können, kann der Wassersperr um 1800 W entfernen der Wärme aus dem 5090-Chip mit der Chip-Temperatur um 80-90 ° C ”

Das stimmt, Ein einzelner Comino -GPU -Wasserblock könnte 1800 W Wärme aus einem einzigen “hypothetischen 5090” entfernen Dies könnte diese Wärmemenge erzeugen, wenn die Kühlmitteltemperatur am Einlass etwa 20 Grad Celsius beträgt und wenn der Kühlmittelfluss mindestens 3-4 Liter pro Minute beträgt.

Das Packen von acht solcher “hypothetischen GPUs” und einigen anderen Komponenten könnte zu einer Gesamtsystemleistung von 15 kW führen, und wenn ein solches System bei Volllast eine konstante Kühlmitteltemperatur von 20 ° C und einen Kühlmittelfluss pro Wassersperr mindestens 3- 4 Liter pro Minute würde ein solches System “normal” funktionieren.

Wer braucht diese Art von Leistung?

Was für ein Benutzer spritzt also auf Multi-GPU-Systemen? Wieder Chistov. „Wenn Sie ein Spieler sind, hat dies keinen Nutzen, um zusätzliche 5090 zu erreichen. Dies hat keine Auswirkungen auf die Leistung, da Spiele nicht mehrere GPUs verwenden können, wie sie es zu einem bestimmten Zeitpunkt verwendet haben, wie sie verwendet wurden. Es gibt mehrere Anwendungen, auf die wir uns für Multi-GPU-Systeme konzentrieren:

- KI -Inferenz: Dies ist die gefragte Arbeitsbelastung. In einem solchen Szenario arbeitet jede GPU “allein” und der Grund, mehr GPUs pro Knoten zu packen wird verwendet, um KI-Anforderungen zu verarbeiten, meistens generative KI, zum Beispiel stabile Diffusion, Midjourney, Dall-e

- GPU-Rendering: beliebte Arbeitsbelastung, skaliert jedoch nicht immer das Hinzufügen von mehr GPUs, z. weniger Leistung pro gpu @ 8-gpus)

- Lebenswissenschaft: Verschiedene Arten von wissenschaftlichen Berechnungen, FOк Beispiel Cryospark oder Relion.

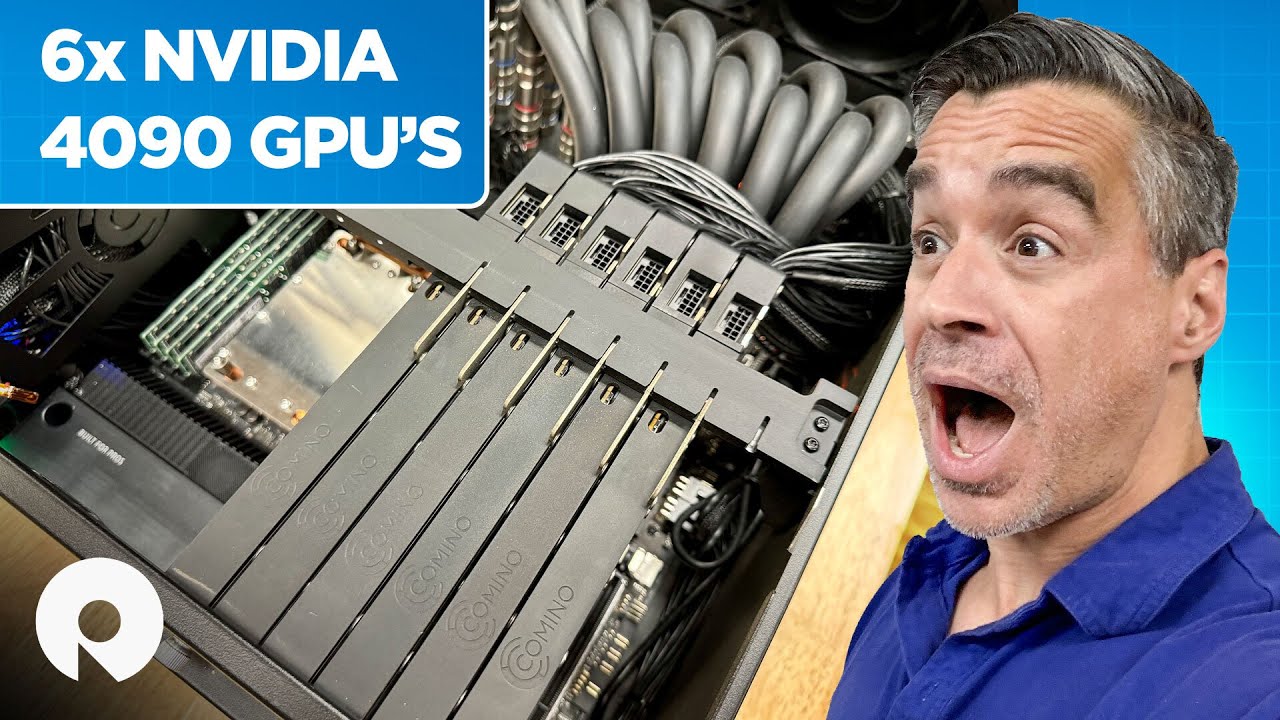

- Jede GPU-gebundene Arbeitsbelastung in einer virtualisierten Umgebung. Mithilfe von Hyper-V oder einer anderen Software können Sie mehrere virtuelle Maschinen erstellen, um jede Aufgabe auszuführen, z. B. Remote-Workstation. Wie Storagereview mit dem getan Grando und sechs RTX 4090 GPUs Es hatte eine Bewertung.

Insbesondere für die RTX 5090 ist die wichtigste Verbesserung der AI -Workloads die 50% ige Verbesserung der Speicherkapazität (bis zu 32 GB), was bedeutet, dass das neue Flaggschiff von NVIDIA für Inferenz besser geeignet ist, da Sie ein weitaus größeres KI -Modell in das Gedächtnis setzen können. Dann gibt es auch die weitaus höhere Speicherbandbreite, die auch hilft.

Achten Sie weiter

In seiner Rezension der RTX 5090John Loeffler von TechRadar nennt es den Supersportwagen der Grafikkarten und fragt, ob es einfach zu mächtig sei, was darauf hindeutet, dass es ein absoluter Völler für die Welt ist.

“Es ist Overkill”, er witzelt: “Besonders wenn Sie es nur zum Spielen wollen, da Monitore, die wirklich mit den Rahmen umgehen können, die diese GPU herausbringen kann, wahrscheinlich Jahre entfernt sind.”

Sie könnten auch mögen

Source link