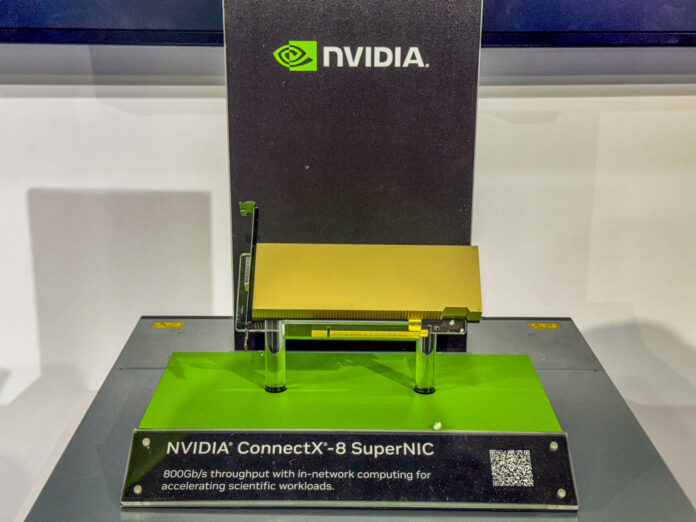

NVIDIAs ConnectX-8 verfügt über ein GPU-inspiriertes Design für die Networking Connectx-8 liefert eine beeindruckende Funktion von 800 Gbit / s durch den Durchsatz von 800 Gbit / s Benötigt PCIe Gen6 X16 für eine optimale Leistung

Nvidia hat den ConnectX-8 Supernic vorgestellt, eine neue Karte, die mit einer 800-Gbit / s-Fähigkeit die 400-Gbit / s-verdoppelte für seinen Vorgänger verzeichneten.

Das Design dieser Karte ist eine Abkehr von herkömmlichen Netzwerk-Schnittstellenkarten (NICs) Layout.

Dieses Gerät wird außerdem mit einem großen Stecker auf der Rückseite geliefert, was auf das Potenzial für Multi-Host-Kabelverbindungen hinweist und möglicherweise mit zusätzlichem CPUs oder als PCIe-Schalterausgabe eine Funktion mit zusätzlichem CPUs verbindet.

Mehrwertverbindungen und Flexibilität

Der Connectx-8-Supernic ist eine Single-Port-Karte, die eine hohe Bandbreite liefert, die eine erweiterte PCIe-Konnektivität erfordert.

Insbesondere erfordert es entweder PCIe Gen6 X16 oder zwei Gen5 X16 -Links, um effektiv zu arbeiten, was darauf hindeutet, dass die Leistung der Karte das überschreitet, was eine einzelne CPU verarbeiten kann. Diese Fähigkeit entspricht der Notwendigkeit einer robusten Konnektivität in den Grace-Plattformen von Nvidia, auf der der Connectx-8 aufgrund der Grenzen von Grace CPUs als kritische Komponente für Hilfsverbindungen dient.

Durch die Integration dieser NICs minimiert NVIDIA die Abhängigkeit von Broadcom -Produkten und verbessert die Systemeffizienz und Flexibilität.

Im Gegensatz zu älteren NIC-Designs mit typischerweise sperrigen Kühlkörpern und einer utilitäreren Ästhetik zeigt der ConnectX-8 eine schlanke Rückplatte und einen Gesamtfaktor, der an moderne GPUs erinnert.

Die Einführung des ConnectX-8 scheint nicht nur in der Ästhetik zu sein, da es darauf hindeutet, dass Nvidia eine breitere Vision für die KI-Infrastruktur hat. Durch die Ausrichtung seiner Netzwerkprodukte mit GPU-ähnlichen Designs zielt das Unternehmen wahrscheinlich darauf ab, seine Integration in Rechenzentren zu optimieren und gleichzeitig Hochleistungsfunktionen zu bieten, die für KI-Arbeitsbelastungen wesentlich sind.

Sie können auch mögen