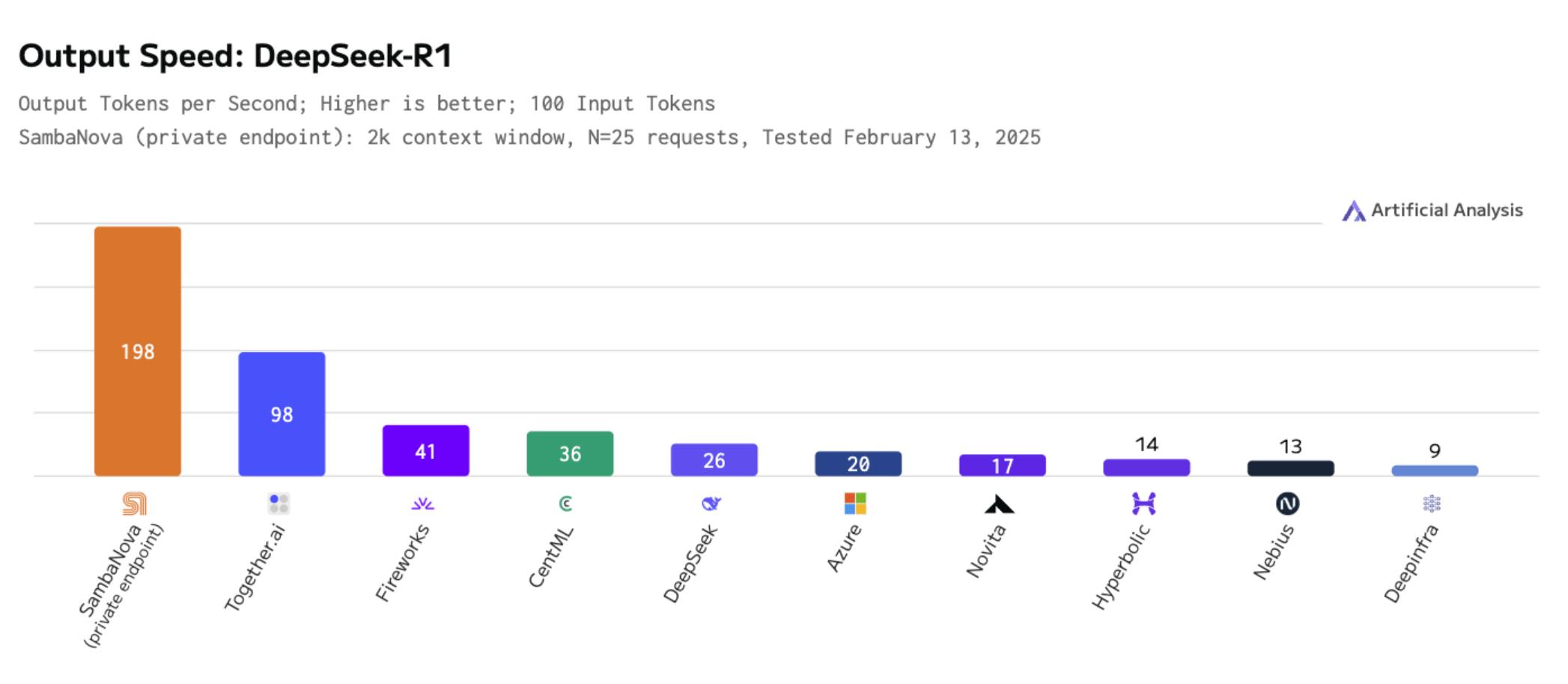

- Sambanova läuft Deepseek-R1 bei 198 Token/Sekunden mit 16 benutzerdefinierten Chips

- Der SN40L RDU -Chip ist angeblich schneller 3x, 5x effizienter als GPUs

- 5x Speed Boost wird in Kürze versprochen, mit einer Kapazität von 100x bis zum Jahresende in der Cloud

Chinesische KI -Aufstart Deepseek hat Sehr schnell machte sich einen Namen Im Jahr 2025, das mit seinem großflächigen Open-Source-Sprachmodell R1 für fortschrittliche Argumentationsaufgaben erstellt wurde und die Leistung der Topmodelle der Branche entspricht und gleichzeitig kosteneffizienter ist.

Sambanova Systems, ein KI-Startup, das 2017 von Experten der Sun/Oracle und der Stanford University gegründet wurde, hat nun angekündigt, was sie behauptet, der weltweit schnellste Einsatz der bisherigen Deepseek-R1 671b LLM.

Das Unternehmen gibt an Nvidia GPUs, das normalerweise erforderlich wäre.

Unabhängig verifiziert

“Sambanova wird vom SN40L RDU-Chip angetrieben und ist die schnellste Plattform, die Deepseek leitet”, sagte Rodrigo Liang, CEO und Mitbegründer von Sambanova. “Dies wird schneller auf 5x steigen als die neueste GPU-Geschwindigkeit eines einzelnen Racks-und bis zum Jahresende bieten wir 100-fache Kapazität für Deepseek-R1 an.”

Während die GPUs von Nvidia traditionell große KI -Workloads angetrieben haben, argumentiert Sambanova, dass seine rekonfigurierbare Datenflow -Architektur eine effizientere Lösung bietet. Das Unternehmen behauptet, seine Hardware liefert das Dreifache der Geschwindigkeit und das Fünffache der Effizienz des führenden GPUs und behält gleichzeitig die volle Argumentationskraft von Deepseek-R1 bei.

“Deepseek-R1 ist eines der fortschrittlichsten verfügbaren Frontier-KI-Modelle, aber sein volles Potenzial wurde durch die Ineffizienz von GPUs eingeschränkt”, sagte Liang. „Das ändert sich heute. Wir bringen den nächsten großen Durchbruch – zusammengebrochene Schlussfolgerungskosten und die Reduzierung der Hardwareanforderungen von 40 Racks auf nur eine -, um Deepseek -R1 mit den schnellsten Geschwindigkeiten effizient anzubieten. “

George Cameron, Mitbegründer der AI-Bewertung des Unternehmens Künstliche Analyse, sagte, sein Unternehmen habe „die Cloud-Bereitstellung von Sambanova durch die vollständigen 671 Milliarden Parameter Deepseek-R1-Mischung von Experten mit über 195 Ausgabe-Token/s unabhängig voneinander verknallt Immer für Deepseek-R1 gemessen. Hohe Ausgangsgeschwindigkeiten sind besonders wichtig für Argumentationsmodelle, da diese Modelle Argumentationsausgangs -Token verwenden, um die Qualität ihrer Antworten zu verbessern. Die hohen Ausgangsgeschwindigkeiten von Sambanova unterstützen die Verwendung von Argumentationsmodellen in latenz-sensitiven Anwendungsfällen. “

Deepseek-R1 671b ist jetzt verfügbar Sambanova Cloudmit API -Zugriff, um Benutzer auszuwählen. Das Unternehmen skaliert die Kapazität schnell und sagt, es hofft, in naher Zukunft 20.000 Token pro Sekunde des gesamten Rack -Durchsatzes zu erreichen.

Sie könnten auch mögen

Source link